Parsero Definition: Unterschied zwischen den Versionen

Zur Navigation springen

Zur Suche springen

| Zeile 5: | Zeile 5: | ||

=Robots.txt= | =Robots.txt= | ||

| − | * | + | *Man kann damit Teile oder eine komplette Website für Webcrawler sperren. |

| − | *Sie ist das erste Dokument das ein Bot beim Crawlen der Website aufruft | + | *Sie ist das erste Dokument das ein Bot beim Crawlen der Website aufruft. |

Aktuelle Version vom 12. August 2021, 14:14 Uhr

Grundlegendes

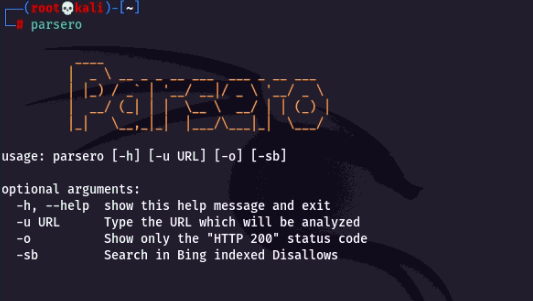

- Parsero liest die Robots.txt eines Web-Servers aus und es werden Disallow-Einträge angezeigt.

- Disallow-Einträge sind die Links die nicht von Suchmaschinen indexiert werden dürfen.

Robots.txt

- Man kann damit Teile oder eine komplette Website für Webcrawler sperren.

- Sie ist das erste Dokument das ein Bot beim Crawlen der Website aufruft.