CEPH Promox Installation Webinterface: Unterschied zwischen den Versionen

Zur Navigation springen

Zur Suche springen

| (17 dazwischenliegende Versionen desselben Benutzers werden nicht angezeigt) | |||

| Zeile 3: | Zeile 3: | ||

=== Voraussetzungen === | === Voraussetzungen === | ||

| + | ===Auf allen Proxmoxen=== | ||

| + | *rm /etc/apt/sources.list.d/pve-enterprise.list | ||

| + | *apt update | ||

| + | |||

* Drei Proxmox-Knoten: | * Drei Proxmox-Knoten: | ||

* pmx1 (10.0.12.201) mit /dev/vdb | * pmx1 (10.0.12.201) mit /dev/vdb | ||

| Zeile 13: | Zeile 17: | ||

# Navigieren Sie zu '''Datacenter'''. | # Navigieren Sie zu '''Datacenter'''. | ||

# Klicken Sie auf '''Ceph'''. | # Klicken Sie auf '''Ceph'''. | ||

| − | # Klicken Sie auf '''Install Ceph'''. | + | # Klicken Sie auf '''Install Ceph'''. |

| + | |||

| + | [[Datei:Pmx-ceph1.png]] | ||

| + | |||

| + | [[Datei:Pmx-ceph2.png]] | ||

| + | |||

| + | [[Datei:Pmx-ceph1-1.png]] | ||

| + | |||

| + | [[Datei:Pmx-ceph4.png]] | ||

| + | |||

| + | [[Datei:Pmx-ceph3.png]] | ||

| + | =Installation auf den beiden anderen Nodes auch durchführen= | ||

| + | *pmx2 und pmx3 | ||

=== Schritt 2: Monitore hinzufügen === | === Schritt 2: Monitore hinzufügen === | ||

| − | # Navigieren Sie zu '''Datacenter''' > '''Ceph''' > '''Monitors'''. | + | # Navigieren Sie zu '''Datacenter''' > '''Node''> '''Ceph''' > '''Monitors'''. |

# Klicken Sie auf '''Create'''. Es öffnet sich ein Dialogfenster. | # Klicken Sie auf '''Create'''. Es öffnet sich ein Dialogfenster. | ||

| − | # Wählen Sie den Knoten ''' | + | # Wählen Sie den Knoten '''pmx2''' und bestätigen Sie die IP-Adresse (10.0.12.202). |

| − | # Wiederholen Sie diesen Schritt für | + | # Wiederholen Sie diesen Schritt für den Knoten '''pmx3''' (10.0.12.203). |

| − | + | [[Datei:Pmx-ceph5.png]] | |

=== Schritt 3: Manager hinzufügen === | === Schritt 3: Manager hinzufügen === | ||

# Navigieren Sie zu '''Datacenter''' > '''Ceph''' > '''Managers'''. | # Navigieren Sie zu '''Datacenter''' > '''Ceph''' > '''Managers'''. | ||

# Klicken Sie auf '''Create'''. Es öffnet sich ein Dialogfenster. | # Klicken Sie auf '''Create'''. Es öffnet sich ein Dialogfenster. | ||

| − | # Wählen Sie den Knoten ''' | + | # Wählen Sie den Knoten '''pmx2''' und bestätigen Sie die IP-Adresse (10.0.12.202). |

| − | # Wiederholen Sie diesen Schritt für | + | # Wiederholen Sie diesen Schritt für den Knoten '''pmx3''' (10.0.12.203). |

| + | [[Datei:Pmx-ceph6.png]] | ||

=== Schritt 4: OSDs hinzufügen === | === Schritt 4: OSDs hinzufügen === | ||

| − | # Navigieren Sie zu '''Datacenter''' > '''Ceph''' > '''OSDs'''. | + | # Navigieren Sie zu '''Datacenter''' > '''Ceph''' > '''node''' > '''OSDs'''. |

# Klicken Sie auf '''Create: OSD'''. Es öffnet sich ein Dialogfenster. | # Klicken Sie auf '''Create: OSD'''. Es öffnet sich ein Dialogfenster. | ||

# Wählen Sie den Knoten '''pmx1''', wählen Sie das Laufwerk '''/dev/vdb''' und klicken Sie auf '''Create'''. | # Wählen Sie den Knoten '''pmx1''', wählen Sie das Laufwerk '''/dev/vdb''' und klicken Sie auf '''Create'''. | ||

# Wiederholen Sie diesen Schritt für die Knoten '''pmx2''' und '''pmx3''', jeweils mit dem Laufwerk '''/dev/vdb'''. | # Wiederholen Sie diesen Schritt für die Knoten '''pmx2''' und '''pmx3''', jeweils mit dem Laufwerk '''/dev/vdb'''. | ||

| + | [[Datei:Pmx-ceph7.png]] | ||

| + | |||

| + | [[Datei:Pmx-ceph8.png]] | ||

=== Schritt 5: Pool erstellen === | === Schritt 5: Pool erstellen === | ||

| − | # Navigieren Sie zu '''Datacenter''' > '''Ceph''' > '''Pools'''. | + | # Navigieren Sie zu '''Datacenter''' > '''Node'''>'''Ceph''' > '''Pools'''. |

# Klicken Sie auf '''Create Pool'''. Es öffnet sich ein Dialogfenster. | # Klicken Sie auf '''Create Pool'''. Es öffnet sich ein Dialogfenster. | ||

| − | # Geben Sie einen Namen für den Pool ein (z.B. ''' | + | # Geben Sie einen Namen für den Pool ein (z.B. '''kit-pool'''). |

# Wählen Sie die Anzahl der '''Placement Groups (PGs)''' aus. Für Testzwecke können 128 PGs ausreichend sein. | # Wählen Sie die Anzahl der '''Placement Groups (PGs)''' aus. Für Testzwecke können 128 PGs ausreichend sein. | ||

# Klicken Sie auf '''Create''', um den Pool zu erstellen. | # Klicken Sie auf '''Create''', um den Pool zu erstellen. | ||

| + | [[Datei:Pmx-ceph9.png]] | ||

| + | |||

| + | [[Datei:Pmx-ceph10.png]] | ||

=== Schritt 6: Überprüfen der Konfiguration === | === Schritt 6: Überprüfen der Konfiguration === | ||

| Zeile 44: | Zeile 67: | ||

# Überprüfen Sie, ob alle Komponenten (Monitore, Manager und OSDs) grün und aktiv sind. | # Überprüfen Sie, ob alle Komponenten (Monitore, Manager und OSDs) grün und aktiv sind. | ||

# Stellen Sie sicher, dass der Cluster-Status '''HEALTH_OK''' anzeigt. | # Stellen Sie sicher, dass der Cluster-Status '''HEALTH_OK''' anzeigt. | ||

| + | [[Datei:Pmx-ceph11.png]] | ||

| + | |||

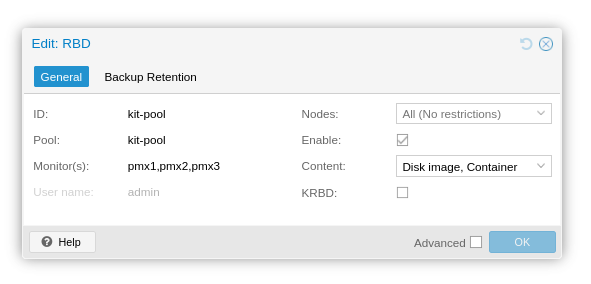

| + | === Storage === | ||

| + | Der Storage sollte schon automatisch als RBD Device erscheinen. | ||

| + | |||

| + | [[Datei:Pmx-ceph-12.png]] | ||

| + | |||

=== Troubleshooting === | === Troubleshooting === | ||

| Zeile 51: | Zeile 81: | ||

<code>journalctl -u ceph-mgr@<hostname></code> | <code>journalctl -u ceph-mgr@<hostname></code> | ||

<code>journalctl -u ceph-osd@<osd-id></code> | <code>journalctl -u ceph-osd@<osd-id></code> | ||

| − | |||

| − | |||

| − | |||

| − | |||

# Überprüfen Sie den Ceph-Cluster-Status über die Kommandozeile: | # Überprüfen Sie den Ceph-Cluster-Status über die Kommandozeile: | ||

<code>ceph -s</code> | <code>ceph -s</code> | ||

| + | ===Benmarks=== | ||

Aktuelle Version vom 12. September 2024, 11:11 Uhr

Installation von Ceph auf allen Nodes

Grafische Installation und Konfiguration von Ceph in Proxmox

Voraussetzungen

Auf allen Proxmoxen

- rm /etc/apt/sources.list.d/pve-enterprise.list

- apt update

- Drei Proxmox-Knoten:

* pmx1 (10.0.12.201) mit /dev/vdb * pmx2 (10.0.12.202) mit /dev/vdb * pmx3 (10.0.12.203) mit /dev/vdb

- Proxmox VE 6.2 oder höher

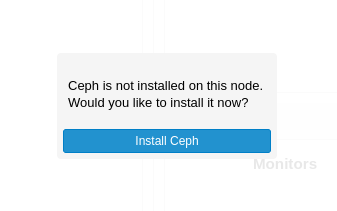

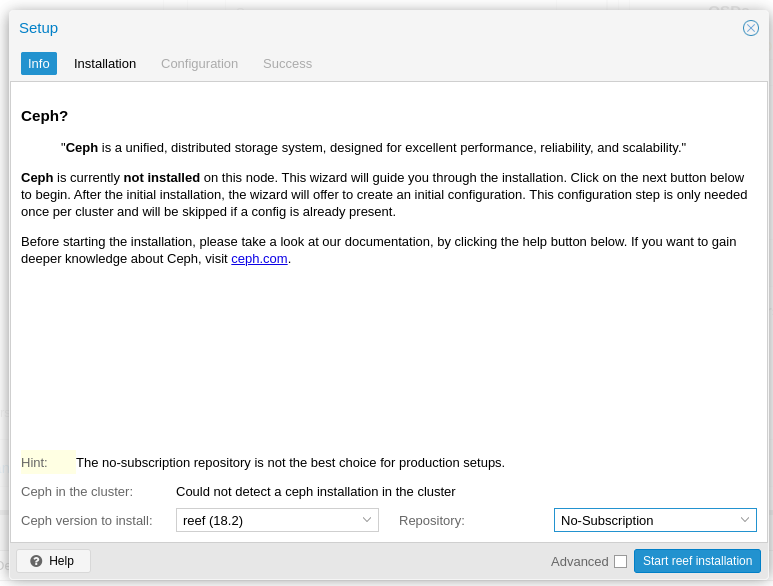

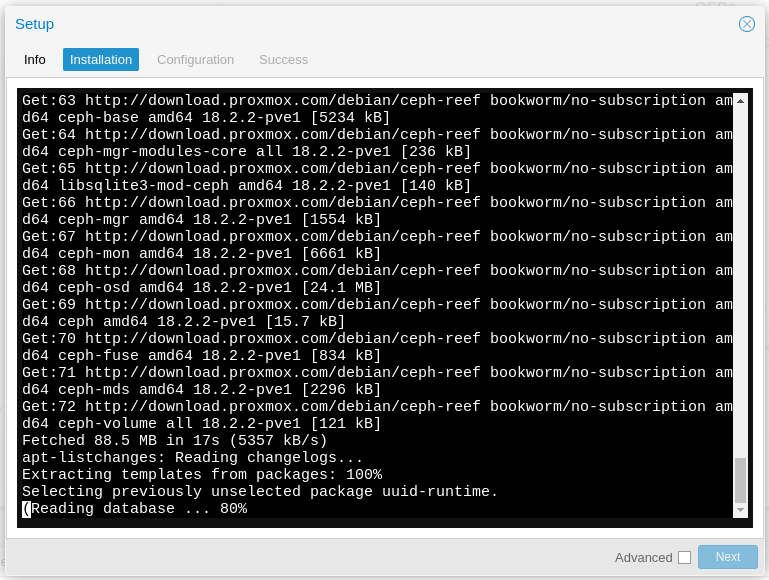

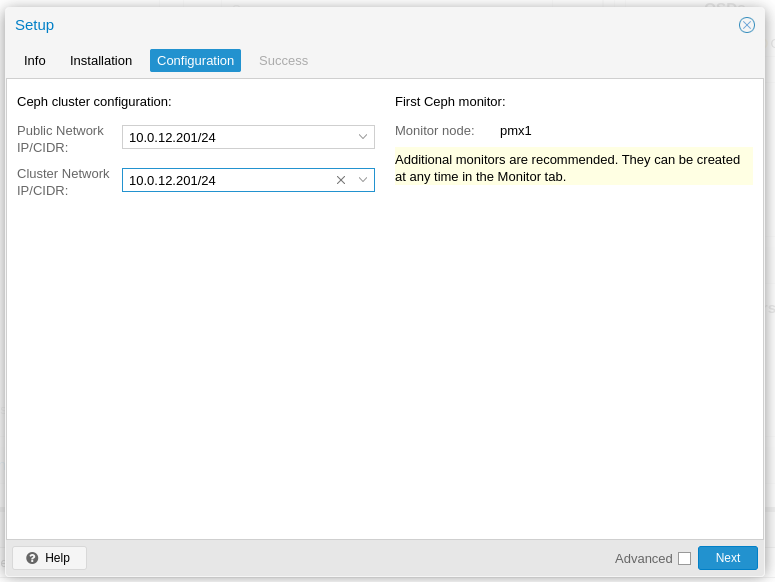

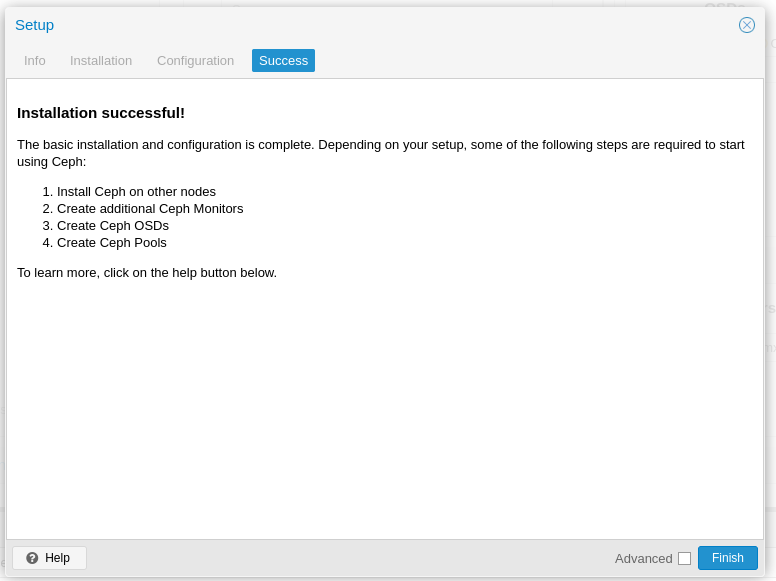

Schritt 1: Ceph-Installation

- Melden Sie sich an der Proxmox Web-GUI an.

- Navigieren Sie zu Datacenter.

- Klicken Sie auf Ceph.

- Klicken Sie auf Install Ceph.

Installation auf den beiden anderen Nodes auch durchführen

- pmx2 und pmx3

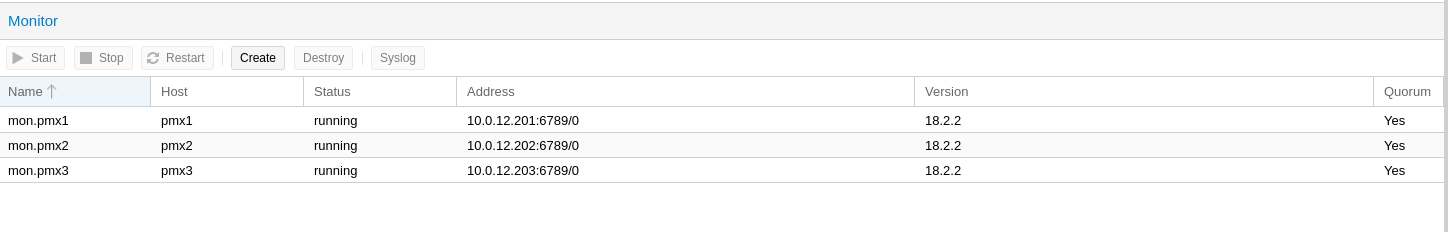

Schritt 2: Monitore hinzufügen

- Navigieren Sie zu Datacenter' > Node> Ceph > Monitors.

- Klicken Sie auf Create. Es öffnet sich ein Dialogfenster.

- Wählen Sie den Knoten pmx2 und bestätigen Sie die IP-Adresse (10.0.12.202).

- Wiederholen Sie diesen Schritt für den Knoten pmx3 (10.0.12.203).

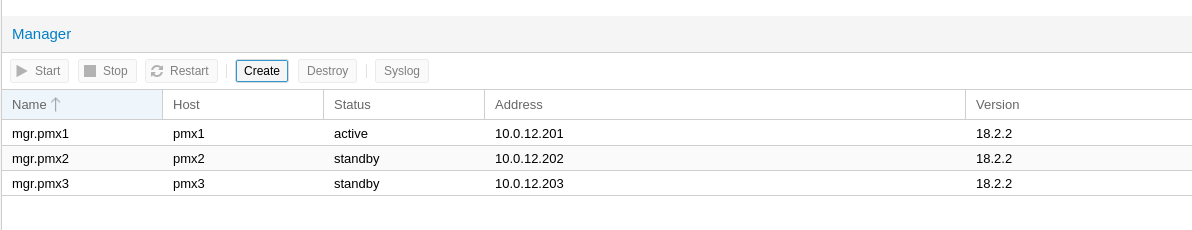

Schritt 3: Manager hinzufügen

- Navigieren Sie zu Datacenter > Ceph > Managers.

- Klicken Sie auf Create. Es öffnet sich ein Dialogfenster.

- Wählen Sie den Knoten pmx2 und bestätigen Sie die IP-Adresse (10.0.12.202).

- Wiederholen Sie diesen Schritt für den Knoten pmx3 (10.0.12.203).

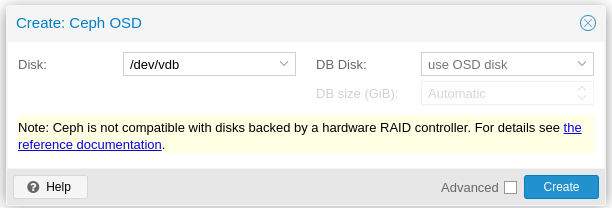

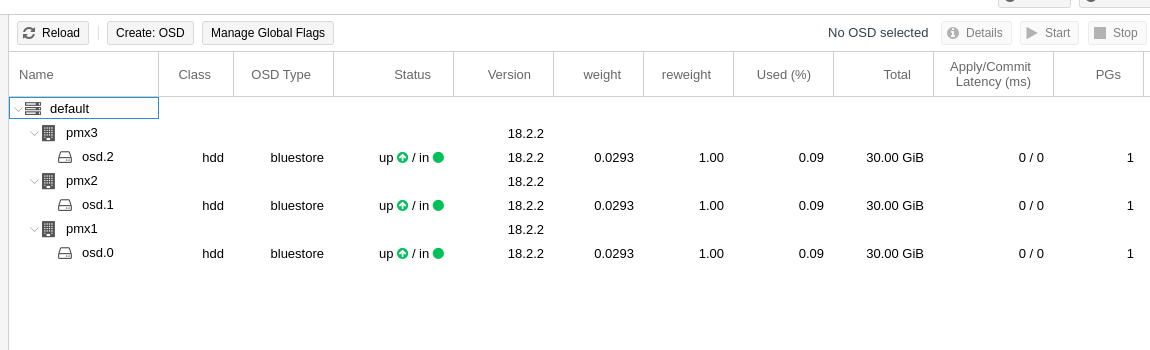

Schritt 4: OSDs hinzufügen

- Navigieren Sie zu Datacenter > Ceph > node > OSDs.

- Klicken Sie auf Create: OSD. Es öffnet sich ein Dialogfenster.

- Wählen Sie den Knoten pmx1, wählen Sie das Laufwerk /dev/vdb und klicken Sie auf Create.

- Wiederholen Sie diesen Schritt für die Knoten pmx2 und pmx3, jeweils mit dem Laufwerk /dev/vdb.

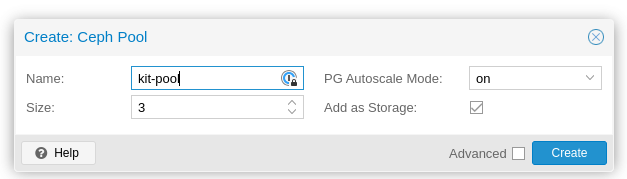

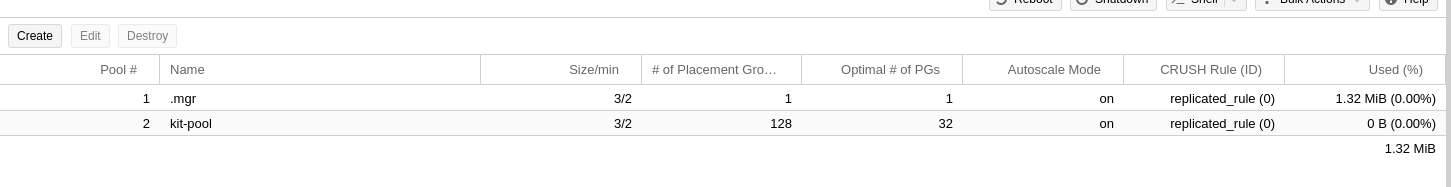

Schritt 5: Pool erstellen

- Navigieren Sie zu Datacenter > Node>Ceph > Pools.

- Klicken Sie auf Create Pool. Es öffnet sich ein Dialogfenster.

- Geben Sie einen Namen für den Pool ein (z.B. kit-pool).

- Wählen Sie die Anzahl der Placement Groups (PGs) aus. Für Testzwecke können 128 PGs ausreichend sein.

- Klicken Sie auf Create, um den Pool zu erstellen.

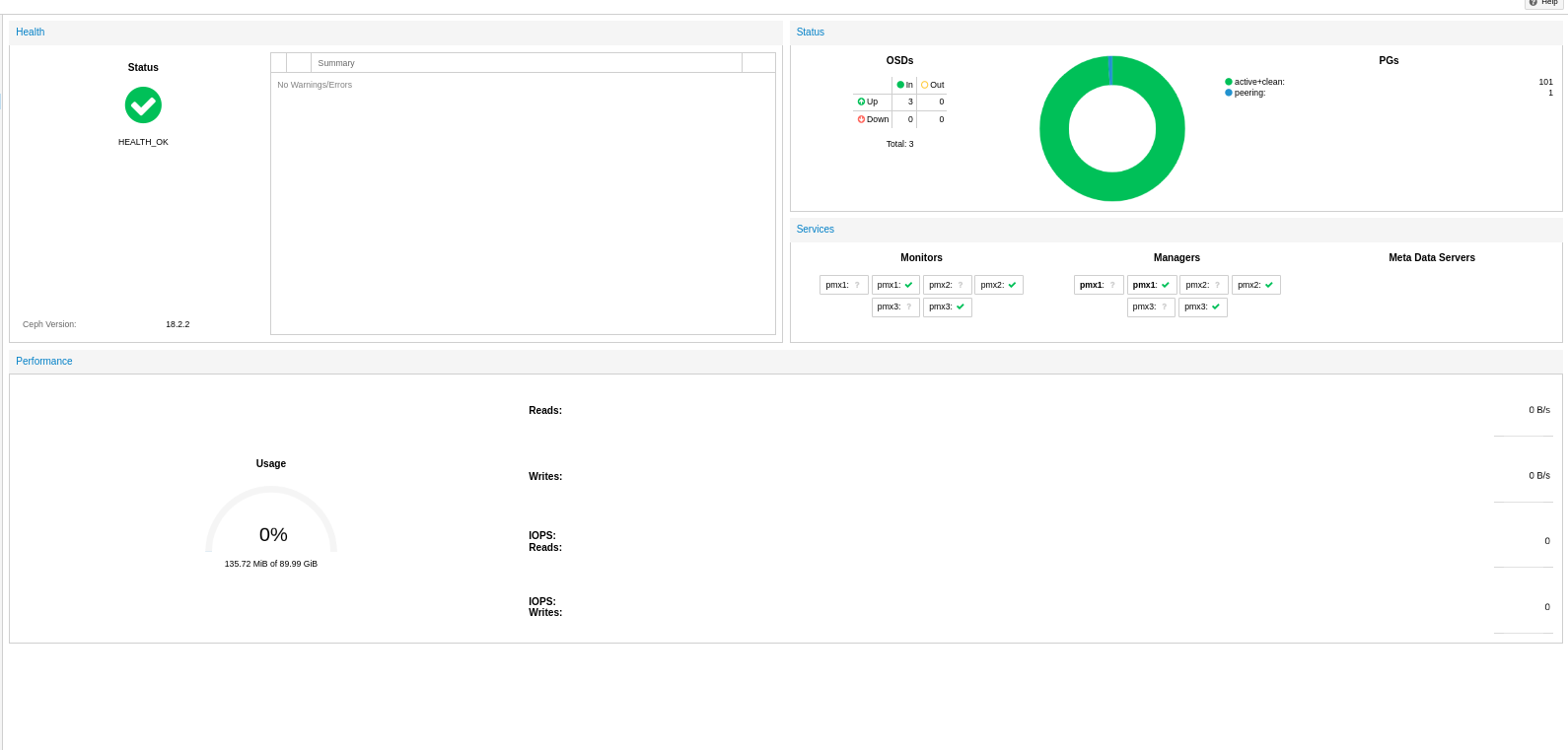

Schritt 6: Überprüfen der Konfiguration

- Navigieren Sie zu Datacenter > Ceph > Status.

- Überprüfen Sie, ob alle Komponenten (Monitore, Manager und OSDs) grün und aktiv sind.

- Stellen Sie sicher, dass der Cluster-Status HEALTH_OK anzeigt.

Storage

Der Storage sollte schon automatisch als RBD Device erscheinen.

Troubleshooting

Falls es zu Problemen kommt:

- Überprüfen Sie die Protokolle auf den einzelnen Knoten:

journalctl -u ceph-mon@<hostname>journalctl -u ceph-mgr@<hostname>journalctl -u ceph-osd@<osd-id>

- Überprüfen Sie den Ceph-Cluster-Status über die Kommandozeile:

ceph -s