Parsero: Unterschied zwischen den Versionen

Zur Navigation springen

Zur Suche springen

| Zeile 8: | Zeile 8: | ||

=Funktion= | =Funktion= | ||

| − | + | Mit dem Befehl '''parsero -u ''''LINK''''''' wird die Robots.txt gelesen | |

| − | + | ||

| − | + | Beispiel: | |

| + | |||

| + | *parsero -u www.facebook.de | ||

oder | oder | ||

| − | + | *parsero -u www.dhs.gov | |

=Befehle= | =Befehle= | ||

Version vom 12. August 2021, 14:08 Uhr

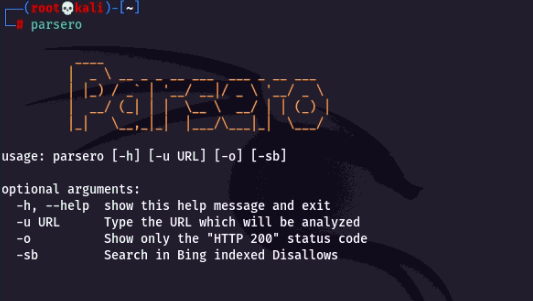

Parsero Definition

- Mithilfe von Parsero wird die Robots.txt eines Web-Servers ausgelesen und die Disallow-Einträge angezeigt.

- Disallow-Einträge sind die Links die nicht von Suchmaschinen wie z.B. Bing. Google, etc. indexiert werden dürfen.

Robots.txt

- Robots.txt ist dafür um die komplette Website, Verzeichnisse, Unterverzeichnisse oder einzelne Dateien für alle Webcrawler oder auch nur für bestimmte zu sperren.

- Sie ist das erste Dokument das ein Bot beim Crawlen der Website aufruft

Funktion

Mit dem Befehl parsero -u ''LINK'' wird die Robots.txt gelesen

Beispiel:

- parsero -u www.facebook.de

oder

- parsero -u www.dhs.gov

Befehle

- parsero -h - Für Hilfe

- parsero -u URL

- parsero -u URL -o - gibt nur HTTP 200 status code anFetter Text

- parsero -u URL -sb - Nur Disallow Einträge für Bing suchen